Einleitung

Zunächst wird die Photoelektronenvervielfacherröhre (phtoto multiplier tube, PMT) kurz beschrieben. Mit dem Verständnis, wie das Licht in elektrisches Signal umgewandelt wird schließt sich dann ein Abschnitt über unterschiedliche Methoden an, wie dieses elektrische Signal primär vom Sensor abgegriffen werden kann. Diese Methoden treffen für alle Sensoren prinzipiell in gleichem Maße zu, wobei es für jeden Sensor besser und schlechter geeignete Umwandlungsverfahren gibt.

Schließlich werden die beiden jüngeren Sensortechniken beschrieben, die (zumindest teilweise) Halbleitertechnologien verwenden: die Lawinen-Photodiode (avalanche photo diode, APD) und der Hybrid-Detektor (hybrid detector, HyD).

Die Photoelektronenvervielfacherröhre

Diese klassische Technologie macht sich den äußeren Photoeffekt zu Nutze, der zunächst kurz beschrieben wird. Damit lässt sich dann verstehen, warum unterschiedliche Materialien für verschiedene Zwecke eingesetzt werden. Die Verstärkung wird dann durch die Erzeugung von Sekundärelektronen bewerkstelligt, die dann in mehreren Stufen nochmals verstärkt werden. Die Verstärkung findet an den sogenannten Dynoden statt. Schließlich müssen die entstandenen vielen Elektronen irgendwo in die äußere Welt abgeführt werden, das übernimmt die Anode.

Photonen zu Elektronen (Kathode)

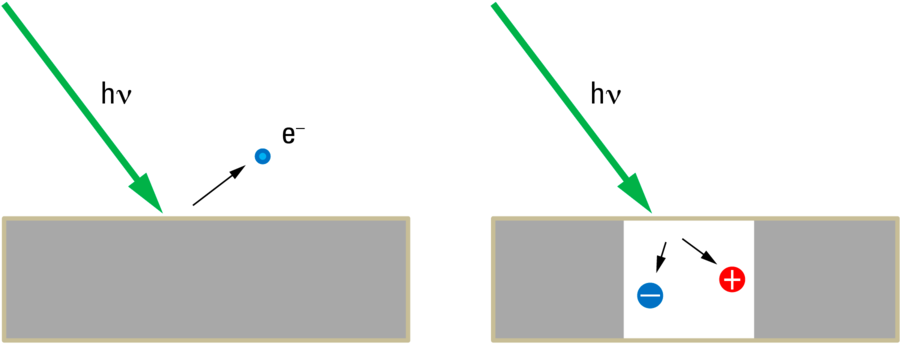

Der äußere Photoeffekt beschreibt die Beobachtung, dass an (zunächst metallischen) Oberflächen freie Elektronen erzeugt werden, wenn man sie mit Licht bestrahlt. Die früheste Beobachtung dieser Art war der „Bequerel-Effekt“, wo an Elektroden in leitenden Flüssigkeiten ein elektrisches Potential beobachtet werden kann, wenn diese Elektroden mit unterschiedlicher Intensität bestrahlt werden [1]. Dieser Effekt, der ähnlich auch bei Halbleitern gefunden wird, heißt heute meist „photovoltaischer Effekt“ und begründet den Boom der Solaranlagen auf Eigenheimen. Dabei werden keine freien Elektronen erzeugt, weshalb man vom „inneren photoelektrischen Effekt“ spricht. Dieser innere Photoeffekt ist für die in Kapitel "Die Lawinen-Photodiode" beschriebenen Lawinen-Photo-dioden wichtig.

Der äußere photoelektrische Effekt wurde von Heinrich Hertz [2] beobachtet und beschrieben. Hier stellte er eine förderliche Wirkung von UV-Licht auf die Erzeugung seiner Funkenstrecken („Tele-Funken“) fest. Wilhelm Hallwachs [3] setzte die Studien an lichtinduzierter Elektrizität fort, weshalb der äußere Photoeffekt dann auch zwischendurch mal Hallwachs-Effekt genannt wurde. Die Deutung und das Verständnis für die gemessenen Phänomene beschrieb Albert Einstein [4]. Er konnte durch Wiederbelebung der Korpuskulartheorie des Lichtes von Newton [5] alle Beobachtungen erklären, die aus der Wellentheorie nicht abzuleiten waren.

Misst man die Anzahl der Elektronen, die bei Bestrahlung einer Elektrode freigesetzt werden (d.h. den Strom, den man über die zweite Elektrode nachweisen kann), dann ist diese Zahl von der Intensität des Lichtes abhängig. Das ist mit der Wellentheorie noch vereinbar: je größer die Feldstärke, desto mehr Energie steht für die Freisetzung zu Verfügung. Untersucht man dagegen, mit welcher kinetischer Energie diese Elektronen ausgestattet sind (die „Startgeschwindigkeit“), dann stellt man fest, dass diese Geschwindigkeit nicht von der Intensität, sondern nur von der Wellenlänge abhängt. Außerdem gibt es eine längste Wellenlänge, oberhalb derer keine Elektronen mehr freigesetzt werden. Diese maximale Wellenlänge ist eine Eigenschaft des Kathodenmaterials. Das widerspricht der wellentheoretischen Vorstellung, dass man nur lange genug Energie zufügen muss – bei schwacher Intensität dann eben etwas länger – um den Empfänger zur Freisetzung anregen zu können.

Die Erklärung für dieses Verhalten lässt sich mit den Photonen als Lichtteilchen (eben den Photonen) zusammenfassen: nachdem schon Max Planck (1900) das Wirkungsquantum eingeführt hatte, um die korrekte Beziehung zwischen Temperatur und Strahlungsenergie beschreiben zu können [6], übertrug Einstein diese Quantelung auf die Lichtenergie selbst. Das Licht wird so in Energiepakete der Größe E = h x c/λ aufgeteilt. Trifft so ein Lichtteilchen einer gewissen Energie E auf die Metalloberfläche, dann kann diese Energie absorbiert werden, und ein Elektron aus dem Materialverband der Kathode lösen. Dazu muss das Photon aber mindestens die Energie haben, die das Elektron an das Material bindet. Das ist die oben erwähnte minimale Energie, die mit der Austrittsarbeit WA bezeichnet wird. Lichtteilchen geringerer Energie können gar keine Elektronen freisetzen, egal wie viele von ihnen pro Zeiteinheit (Intensität) auf die Oberfläche auftreffen. Da c und h physikalische Konstanten sind, hängt die Energie der Photonen nur von der Wellenlänge λ ab, und zwar umgekehrt proportional. Ab einer gewissen Wellenlänge λmin ist die Energie der Photonen E = c/λmin also kleiner als die Austrittsarbeit, und das Messgerät zeigt keinen Strom an.

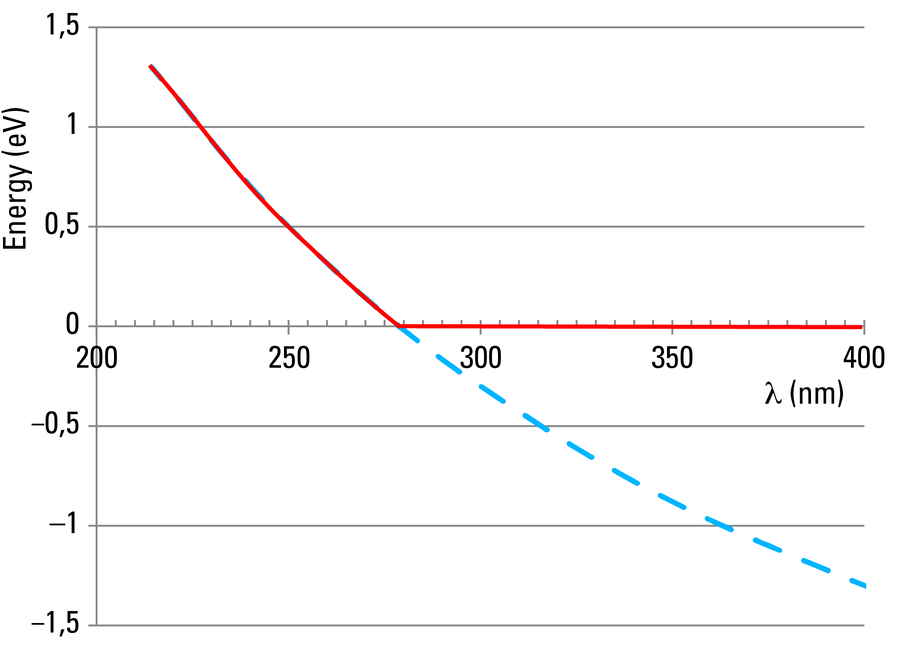

Photonen mit kürzerer Wellenlänge können Elektronen freisetzen und man findet, dass ihre kinetische Energie linear mit der Wellenlänge zusammenhängt: Ekin = h*c/λ – WA, aber unabhängig von der Strahlungsintensität (Photonendichte) ist. Bei höherer Intensität werden zunächst einfach mehr freie Elektronen erzeugt.

In Abbildung 2 ist diese Abhängigkeit für Zink dargestellt. Wie man aus der roten Kurve erkennen kann, muss die Wellenlänge des Lichts 280 nm oder kürzer sein, um einen Photoeffekt nachweisen zu können. Für sichtbares Licht sind deshalb Zink-Kathoden nicht geeignet. Man versucht hier, Materialien mit möglichst geringer Austrittsarbeit zu finden. Wie man aus dem Periodensystem absehen kann, sind dafür Alkalimetalle besonders gut geeignet, da deren äußeres Elektron nur ganz schwach an den Atomrumpf gebunden ist. Daher sind die wirksamen Bestandteile von Photokathoden üblicherweise Alkalimetalle oder deren Mischungen (z.B., Cs, Rb, K, Na). Um auch im sichtbaren Bereich gute Ergebnisse zu erzielen, werden heute auch oft Halbleiter-Kristalle im Photokathodenmaterial verwendet (z.B. GaAsP). Viele Details kann man im Handbuch für Photomultiplier von Hamamatsu [7] finden. Das gilt auch für alle folgenden Abschnitte, insbesondere für Eigenschaften von Photomultipliern.

Ein wichtiger Parameter bei der Auswahl der Sensoren ist die Quanteneffizienz der Photokathode. Damit ist das Verhältnis zwischen eintreffenden Photonen und erzeugten Photoelektronen gemeint. Alkali-Photokathoden liefern zwischen 300 nm und 600 nm gute Ergebnisse und kommen dabei auf Effizienzen bis zu etwa 30% im blauen Bereich des Spektrums. Halbleiter-Varianten erreichen bis zu 50% und können zwischen 400 nm und 700 nm (GaAsP) bzw. 900 nm (GaAs) eingesetzt werden. Halbleiter-Photokathoden werden deshalb zunehmend für Untersuchungen im biomedizinischen Bereich eingesetzt, wo größere Wellenlängen erwünscht sind, da die in dicken Präparaten ein merkliches Problem darstellende optische Streuung, mit der vierten Potenz der Wellenlänge abnimmt.

Für die unterschiedlichsten Anwendungen in den entferntesten Anwendungsgebieten gibt es daher eine große Zahl von Varietäten, die sich in ihrer spektralen Empfindlichkeit, ihrer Quanteneffizienz und ihrer zeitlichen Auflösung unterscheiden.

Die Vervielfachung (Dynoden)

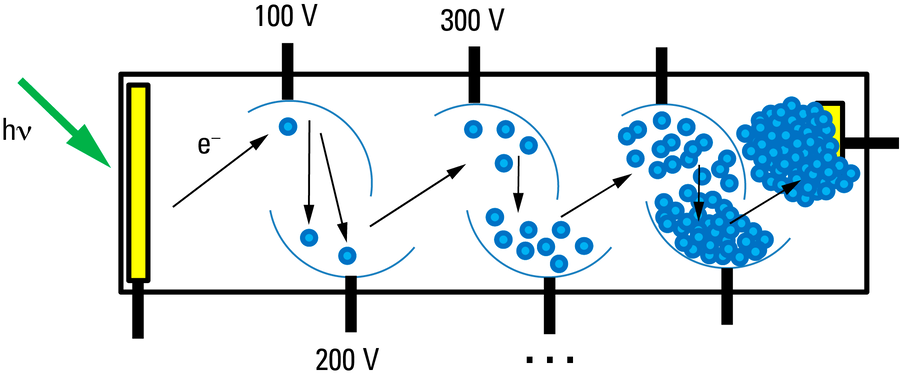

In der Photokathode wird durch jedes eintreffende und wirksame Photon ein Elektron freigesetzt. Dieses Photoelektron ist natürlich ebenso schlecht messbar, wie ein einzelnes Photon. Im Gegensatz zu Photonen kann man Elektronen aber sehr einfach manipulieren: durch eine elektrische Gleichspannung lässt sich die Energie des Elektrons erhöhen. Durchläuft das freie Elektron bis zu seiner Ableitung eine Spannung U, dann nimmt es die Energie e x U auf, die in einer Vakuumröhre als kinetische Energie dem Elektron zugeführt wird. Beträgt die Potentialdifferenz beispielsweise 1000 Volt, dann erhält das Elektron 1000 eV (Elektronenvolt) kinetische Energie. Ein Photon von 620 nm hat etwa 2 eV. Wie man sieht, kann man durch eine Beschleunigung des Photoelektrons über eine hohe Spannung dem Signal „ein Photon“ eine sehr viel größere Energie zuordnen, als das Photon selbst mitbringt: das ist eine Verstärkung des Signals.

In einem klassischen PMT wird diese Verstärkung auf mehrere Stufen verteilt. Hinter der Photokathode findet sich eine Elektrode, die mit einer positiven Spannung, typischerweise zwischen 50 und 100 Volt belegt ist. Das freigesetzte Photoelektron wird von diesem positiven Potential angezogen und beschleunigt in diese Richtung, bis es schließlich dort einschlägt. Die kinetische Energie wird hier – ganz ähnlich wie an der Photokathode nach Absorption eines Photons – in die Freisetzung mehrerer weiterer Elektronen umgesetzt („Sekundär-Elektronen“). Typische Werte liegen bei 2 bis 4 Sekundärelektronen.

Um eine messbare Ladung zu erzeugen, wird dieser Vorgang nun mehrmals in einer Kaskade wiederholt, sodass beispielsweise bei 3 Sekundärelektronen pro Elektrode (hier Dynode genannt) insgesamt 3k Elektronen freigesetzt werden, wobei k die Anzahl der Dynoden bezeichnen soll. Typisch werden PMTs mit etwa 10 Dynoden hergestellt, das sind dann zusammen 310 = 60.000 Elektronen – eine messbare Ladung von 10 fC.

Die Gesamtverstärkung des Photoelektronenvervielfachers kann über die gesamte Hochspannung geregelt werden, die üblicherweise durch Spannungsteilung gleichmäßig auf die Dynoden verteilt wird. Je höher die Spannung, desto größer die Verstärkung. Die Anzahl der freigesetzten Elektronen an jeder Dynode ist dabei ein Mittelwert, der sich durch die Spannung kontinuierlich einstellen lässt. Darum kommen hier auch so etwas merkwürdige Zahlen wie beispielsweise „2,7 freigesetzen Elektronen“ vor

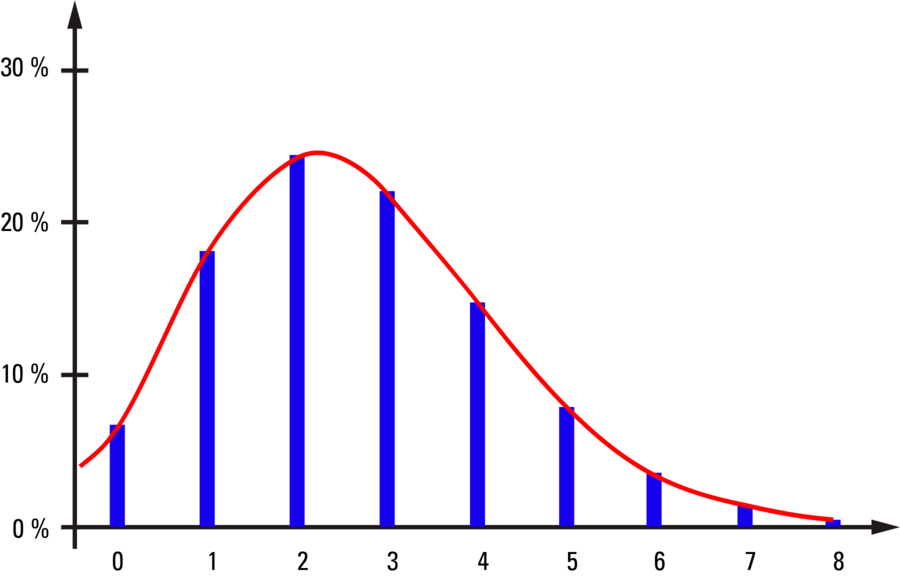

In Abbildung 4 ist für das Beispiel 2,7 Elektronen die Häufigkeitsverteilung wiedergegeben, die beschreibt, wieviel Elektronen tatsächlich an einer Dynode aus einem ankommenden Elektron freigesetzt werden. Die meisten Ereignisse liefern ein, zwei, drei oder vier Elektronen, gelegentlich aber auch noch mehr. An den „späten“ Dynoden werden diese Ereignisse bei jedem Eintreffen eines Elektronenschauers von der vorhergehenden Dynode gemittelt, und man erhält für jeden Puls etwa eine 2,7-fache Verstärkung. Bei der ersten Dynode kann aber nicht gemittelt werden, da nur ein einziges Elektron eintrifft. Die Verteilung in Abbildung 4 ist also auch näherungsweise die Verteilung der Pulshöhen am Ausgang des PMT, woraus man erkennen kann, dass dieser Wert um einen Faktor 4 bis 5 schwankt. Die einzelnen Photonen werden also sehr unterschiedlich verstärkt, was bei integrativen Messmethoden (siehe unten) ein signifikanter Beitrag zum Rauschen ist. Möchte man die Photonen zählen, dann ergeben sich aus diesen unterschiedlichen Pulshöhen ebenfalls Schwierigkeiten bei der Diskriminierung.

Weiter ist es durchaus möglich, dass Elektronen auch nicht auf das Ziel – die nächste Elektrode – treffen. Je nachdem, auf welcher Stufe das geschieht, wird die gesamt-Ladung weiter ungenau, und die Effizienz wird dadurch herabgesetzt. Statt von der Quanteneffizienz der Photokathode spricht man daher oft auch von der „Detektionseffizienz“, bei der auch Verluste an der gesamten Kette berücksichtigt werden.

Das Signal (Anode)

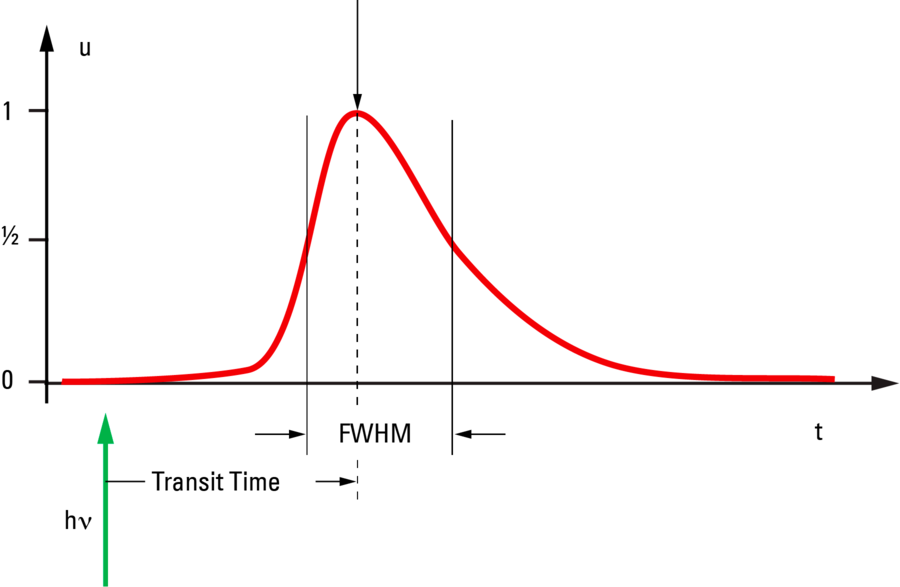

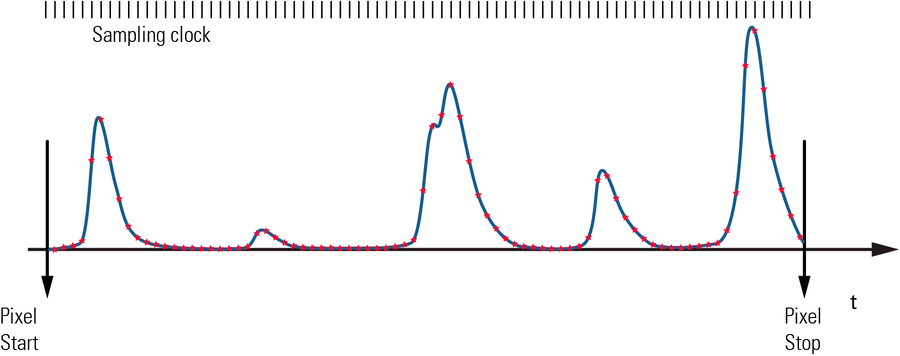

Nach der Verstärkung durch die gestufte Hochspannung erreichen die Elektronen schließlich die Anode, an der die Ladung gemessen werden kann. Durch die unterschiedlichen Wege, die die Elektronen in der Röhre nehmen können, treffen nicht alle Elektronen gleichzeitig ein. Auch hier sind die Ereignisse verteilt, und die zeitliche Verteilung spiegelt sich in der Breite des idealen elektrischen Pulses wieder. Tatsächlich wird die Pulsform durch die Messanordnung stark beeinflusst, und die gemessene Pulsbreite ist eine Faltung der Verteilung der eintreffenden Ladungen mit den Dämpfungseigenschaften der nachgeschalteten Elektronik.

Zur Charakterisierung der Pulsform zieht man die Halbwertsbreite (full width half maximum, FWHM) heran, die für PMTs etwa zwischen 5 und 25 ns liegt. Der Puls ist natürlich länger als die Halbwertsbreite an der Anode wirksam, und man kann für die Zeit zwischen 10% angestiegen und 90% abgefallen etwa das Doppelte der FWHM annehmen. Die Form ist aber nicht symmetrisch, vielmehr ist der Anstieg zwei- bis dreimal schneller als die Abklingzeit. Man kann das etwas hemdsärmelig mit den Tropfen vergleichen, die ein Hund nach dem Bade verspritzt: zunächst wird die Tropfenzahl stark ansteigen, dann – weil der Vorrat immer geringer wird – langsam wieder nachlassen.

Die Zeit, die zwischen Eintreffen des Photons an der Kathode und dem Maximum des Ausgangspulses liegt, ist die Transit-Zeit (transit time, TT), die je nach Konstruktionsprinzip etwa zwischen 15 und 70 ns liegt. Es ist die Zeit, die das Signal in der Röhre unterwegs ist. Auch diese Zeit ist zufällig um einen Mittelwert verteilt, und die Breite der Verteilung (transit time spread, TTS) liegt bei 1 bis 10 ns. Für Anwendungen im Bereich der Fluoreszenz-Lebensdauer ist dies ein wichtiger Parameter, da er die Genauigkeit der Messungen begrenzt.

Auch, wenn gar keine Photonen auf die Kathode treffen, wird man mit einer gewissen Häufigkeit Ereignisse an der Anode messen. Diese werden vor allem durch thermische Elektronen ausgelöst, die von der Kathode emittiert werden. Auch von den Dynoden können thermische Elektronen zu kleineren Ereignissen führen. Diese Ereignisse werden als „Dunkelrauschen“ bezeichnet und verringern den Kontrast, was insbesondere bei schwachen Signalen dazu führt, dass das Signal nicht mehr vom Hintergrund unterschieden werden kann. Bei einem PMT wird das Rauschen der Photokathode und der frühen Dynoden durch die nachfolgenden Stufen natürlich weiter verstärkt. Bei einstufigen Systemen ist das nicht der Fall. Ein zweistufiger Hybrid-Detektor (siehe Kapitel "Hybrid-Detektor") zeigt daher auch viel weniger dieses multiplikativen Rauschens.

Messmethoden und Histogramme

Die an der Anode ankommende Ladungswolke hat einen Spannungspuls zur Folge. Genauer wird das angelegte positive Potential der Hochspannung pulsförmig durch die eintreffende negative Ladung etwas abgesenkt. Die Ladung ist zwar nun messbar, aber immer noch sehr klein. Darum muss durch sorgfältiges Design sichergestellt werden, dass das Ergebnis signifikant vermessen werden kann. Im Prinzip werden drei verschiedene Konzepte zur Messung ver-wendet, die hier skizziert werden sollen. Sie sind für alle Sensoren gültig, also auch für die unten beschriebenen Lawinen-Photodioden und Hybrid-Detektoren, wobei sich die Methoden nicht für alle Sensoren gleichermaßen gut eignen.

Bei dieser Gelegenheit soll auch auf die Auswertung kurz eingegangen werden, da der Benutzer ja nicht primär an der Funktion des Sensors interessiert ist, sondern daran, was diese Signale für seine Messungen und seine Forschung bedeuten.

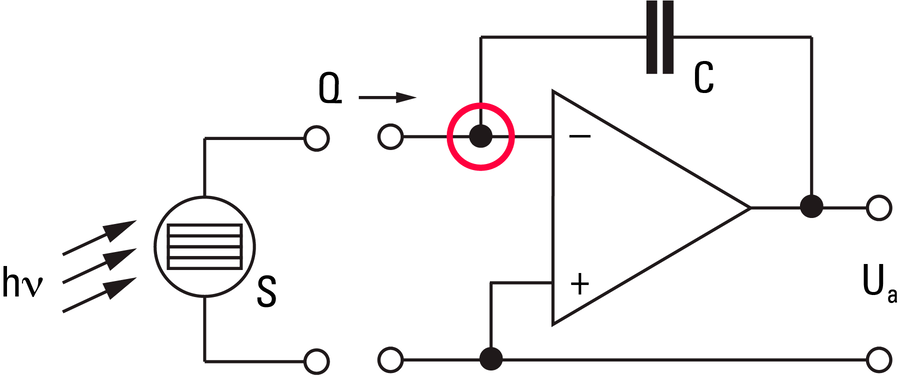

Der Ladungsverstärker

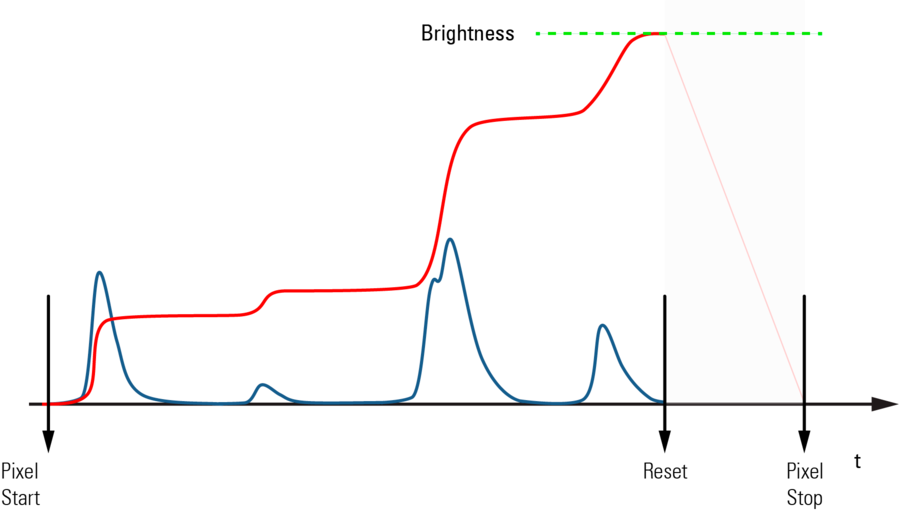

Das herkömmliche Verfahren zur Messung des PMT-Signals ist der Einsatz eines sogenannten Ladungsverstärkers. In einem Rastermikroskop wird der Beleuchtungsstrahl ja ständig über die Probe bewegt, und man muss jede Zeile in die gewünschte Anzahl von Bildelementen (Pixel) unterteilen. Eine typische Aufnahme für klassische Strukturbilder dauert etwa eine Sekunde, bei 1000 Zeilen pro Bild und 1000 Pixeln pro Zeile. Die Aufnahmezeit für einen Bildpunkt dauert dann 1 Mikrosekunde. In dieser Mikrosekunde wird alle vom PMT kommende Ladung in einer Kapazität aufsummiert, wie in Abbildung 7 skizziert. Dabei geht ein Bruchteil der Gesamtzeit für das Zurücksetzen des Ladungsverstärkers verloren, der ja für das nächste Pixel wieder bei Null beginnen muss. Das Ergebnis ist eine Spannung, die proportional zur gesamten vom PMT geflossenen Ladung ist. Diese Spannung wird anschließend durch einen analog-digital Wandler (ADC) in „Grauwerte“ umgewandelt. Üblicherweise verwendet man dabei 8-bit Auflösung, das heißt die Grauwerte nehmen ganze Zahlen zwischen 0 und 255 an. Durch Veränderung der Hochspannung am PMT kann man dafür sorgen, dass das gemessene Signal gerade eben in diese 8 bit „hineinpasst“, also keine Übersteuerung das Signal abschneidet aber der gesamte dynamische Bereich ausgenutzt wird.

Es ist offensichtlich, dass diese Grauwerte keine absoluten Helligkeitswerte vermitteln, sondern nur als relative Helligkeiten unterschiedliche Bereiche des Bildes vergleichen können – oder Helligkeiten zwischen Bildern, die unter identischen Einstellungen des Messverfahrens entstanden sind. Bei jedem eintreffenden Photon ist ja wie oben be-schrieben die Signalhöhe recht unterschiedlich. Während in einem Bildelement die Helligkeit gemessen wird, treffen aber häufig mehrere bis viele Photonen während der Messzeit ein. Die möglichen Werte sind dann alle Kombinationen aus den ohnehin schon quasi kontinuierlich verschiedenen Ladungsmengen für ein einzelnes Photon. Deshalb sind die Photonen-Ereignisse bei einer summierenden Messung völlig verwischt und man findet ein Kontinuum von Signalhöhen. Der Digitalisierungsvorgang macht dann daraus 256 diskrete Helligkeiten, die Grauwerte.

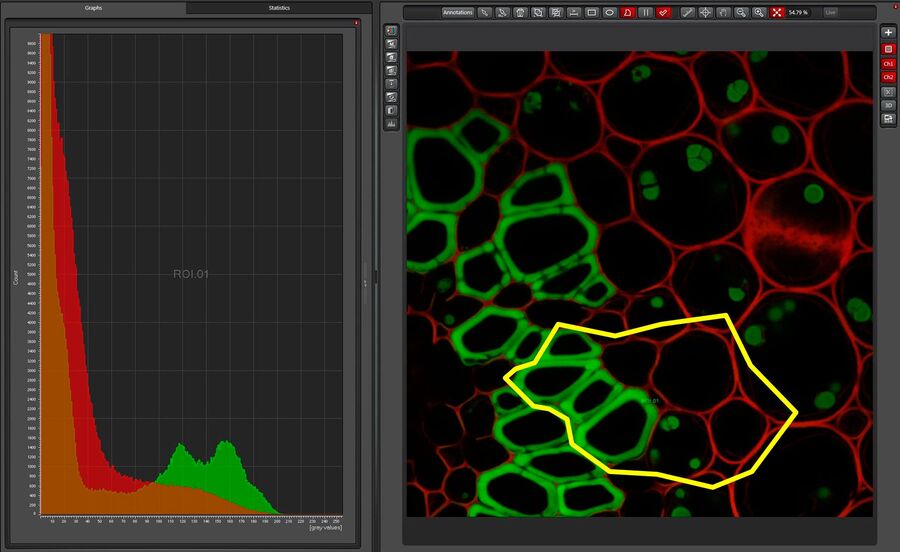

Der Experimentator ist natürlich in der Regel nicht an der Helligkeit einzelner Bildelemente interessiert, sondern an der Intensität einer Struktur, beispielsweise einer ganzen Zelle oder eines Gewebebestandteiles. Dazu wählt er aus dem Bild den Bereich aus, der ihn interessiert (ROI, region of interest) und fragt nach dessen Helligkeit. Je nach Bildauflösung, die meist etwa bei 1000 x 1000 Pixel, also „1 Megapixel“ liegt, werden dabei viele Hundert oder sogar Tausende von Bild-elementen in einer Zahl zusammengefasst. Dieser Mittelwert kann dann mit Werten aus anderen Strukturen verglichen werden, oder als zeitliche Änderung in einem Experiment mit lebendem Material aufgezeichnet werden und vieles mehr. Es ist aber auch möglich, die Verteilung der Helligkeiten in diesem Bereich genauer zu analysieren. Dazu bedient man sich einer Darstellung in einem Histogramm. Hier wird gezählt, wie viele Bildelemente eine bestimmte Helligkeit aufweisen. Da es 256 verschiedene Helligkeiten gibt, findet man auf der x-Achse eines 8-bit Histogramms auch die Zahlen von 0 bis 255. Durch die Digitalisierung gibt es im Gegensatz zum Mittelwert hier keine Zwischenwerte; korrekterweise sollte in einem Histogramm deshalb auch keine durchgezogene Linie erscheinen. Auch die Häufigkeiten, die auf der y-Achse aufgetragen werden, sind zunächst sinnvollerweise nur ganze Zahlen, weil sie ja die Anzahl der Bildelemente wiedergeben. Ein solches Histogramm ist in Abbildung 8 dargestellt. Man kann aus die-sem Histogramm vielerlei Details ablesen. Wir interessieren uns hier für drei Eigenschaften:

Falls die Helligkeiten so verteilt sind, dass die Kurve symmetrisch ist, dann ist der Mittelwert der Helligkeiten beim Maximum des Histogramms zu finden. Häufig findet man allerdings eine gewisse Schiefe, dann ist der Mittelwert etwas neben das Maximum verschoben.

Wenn die Helligkeiten sehr stark streuen, wird die Kurve sehr „breit“. Wenn es gar keine Streuung gäbe, dann käme nur ein Grauwert vor, und die „Kurve“ wäre dann beliebig schmal. Aus der Breite kann man daher auf die Streuung schließen. Einfluss auf diese Streuung hat aber nicht nur die Verteilung der Photonenanzahl, die pro Messzeit in einem Bildelement eintreffen, sondern auch die Rauscheigenschaften des Messsystems, hier insbesondere des PMTs, aber auch der zugehörigen Elektronik. Nur, wenn diese Rauschanteile klein genug sind, kann man die Zahl der beitragenden Photonen abschätzen, die sich dann aus dem Verhältnis des Mittelwertes zur Breite ergibt.

Da der Nullpunkt durch die Einstellung der Elektronik festgesetzt ist, kann man aus einem Grauwert-Histogramm nicht ablesen, wie groß der Anteil des Dunkelstromes des PMT an der Hintergrund-Helligkeit ist.

Für ein brauchbares Bild benötigt man ein Signal-Rausch-Verhältnis (SNR, singal to noise ratio) von etwa 3. Das erreicht man, wenn in einem Bildelement 10 Photonen registriert werden. Bei einem Bild mit 1 Mpix und einer Zeilenfrequenz von 1 kHz sind das 10 Millionen Photonen pro Sekunde. In aller Regel bemüht man sich aber, mit weniger Licht auszukommen, denn hohe Beleuchtungsintensitäten zerstören die Fluoreszenzfarbstoffe und die entstehenden Bruchteile sind oft giftige Chemikalien für das lebende Material. Darum reduziert man die Beleuchtung so lange, bis ein guter Kompromiss zwischen Bildqualität und Probenstabilität gefunden ist. Häufig wird man daher im Mittel nur 1…3 Photonen und weniger per Pixel registrieren. Ganz schwache, aber noch auswertbare Signale haben als Mittelwert deutlich weniger als ein Photon pro Pixel.

Wieso bekommt man nun deutlich über 200 verschiedene Grauwerte, wenn man doch nur 10 Photonen zur Verfügung hat? Müssten da nicht etwa 15 unterschiedliche Helligkeitsstufen ausreichen? Tatsächlich träfe das zu, wenn jedes Photon das gleiche Signal im Bild erzeugte. Wir haben aber oben festgestellt, dass die Pulshöhen sehr stark variieren (die Intensität ist verrauscht). Wenn in einem Pixel die Pulse von mehreren Photonen summiert werden, dann wird die mögliche Zahl von Helligkeitswerten nochmals vervielfacht. Deshalb finden wir sehr viele Helligkeitsstufen. Und je mehr Stufen wir verwenden (tiefere Grau-Auflösung, etwa mit 12 oder 16 bit), desto höher bewerten wir das durch Variation der Pulse erzeugte Rauschen. Im Ergebnis bekommen wir aber keine bessere Information.

Die Histogramme geben auch weitere aufschlussreiche Information. Hat man bei der Aufnahme nicht den ganzen Dynamik-Bereich von 0 bis 255 ausgeschöpft, sondern beispielsweise nur das untere Zehntel zwischen 0 und 25, dann erscheint das Bild auf dem Monitor sehr dunkel. Der Monitor benutzt ja dann auch nur die Grauwerte von 0 bis 25. Wir können nur das Bild heller machen, indem wir das Histogramm „spreizen“, ein gängiges Verfahren, das sogar jede Digitalkamera heute automatisch mit anbietet. Dabei wird die Helligkeit in jedem Pixel mit jeweils der gleichen Zahl Z multipliziert. Im angenommenen Fall würde man alle Werte mit 10 multiplizieren, um den Bereich von 0 bis 255 auszuschöpfen. Da ursprünglich aber nur 25 x-Werte vorhanden waren, sind auch im Ergebnisbild nur 25 x-Werte zu finden. Das Histogramm hat also Lücken, in unserem Beispiel fehlen zwischen allen belegten Grauwerten 9 Werte. Die Graphen sehen deshalb etwas „unordentlich“ aus, sind aber völlig korrekt.

Obwohl sich der Ladungsverstärker lange als Messeinrichtung für PMT-Signale an konfokalen Mikroskopen gehalten hat, wird er dennoch heute meist durch andere Verfahren ersetzt (siehe unten). Der Ladungsverstärker liefert Signale, die über ein ganzes Pixel aufsummiert sind, das Ergebnis hängt also von der Länge der Pixelzeit ab. Diese Pixelzeit ändert sich aber, wenn beispielsweise das Rasterformat verändert wird, d.h. wenn etwa statt 1000 nur 100 Pixel pro Zeile bei gleicher Scangeschwindigkeit registriert werden. Das Signal ist dann 10-fach höher und die Hochspannung am PMT muss deshalb angepasst werden. Auch eine Änderung der Scangeschwindigkeit hat dieselbe Auswirkung. Dazu kommt, dass in jedem Pixel etwas Messzeit verloren geht, weil die Rücksetzung des Ladungsverstärkers auch etwas Zeit braucht. Bei hohen Scangeschwindigkeiten mit hoher Auflösung werden die Pixel sehr kurz, und der Reset-Verlust wird merklich. Die direkte Digitalisierung schafft hier Abhilfe.

Direkte Digitalisierung

Moderne Digitalisierungs-Schaltkreise sind schnell genug, um das Signal am PMT direkt in digitale Einheiten umzusetzen. Dazu wird die Ladung am PMT über einen geeignet dimensionierten Widerstand abgeleitet und die dabei auftretende Spannung mit hoher Taktrate in Grauwerte umgesetzt. Während der Aufnahme eines einzigen Bildelementes werden diese Daten dann sofort gemittelt und das Bild enthält folglich Grauwerte, die wirk-lich die Intensität der Probe repräsentieren, unabhängig davon, wie lange die Aufnahme eines Bildelementes dauert. Man braucht daher die Hochspannung am PMT nicht nachregulieren und kann insbesondere die Helligkeiten direkt vergleichen. Außerdem gibt es keine Verluste durch Reset-Zeiten.

Die Histogramme sehen bei direkter Digitali-sierung genauso aus, wie bei Verwendung eines Ladungsverstärkers und haben prinzipiell auch denselben Informationsgehalt. Das Mittelungsverfahren addiert im Grunde auch die Messwerte, skaliert sie aber sofort auf die korrekte Zeitachse. Auch der Scan-Zoom ändert hier nicht die Helligkeit des Bildes, außer bei wirklichen Helligkeitsänderungen, etwa durch unterschiedlich starkes Ausbleichen des Farbstoffes – das ist aber eine wertvolle Information und kein Messartefakt – das Bleichen lässt sich hier sofort quantifizieren.

Daneben hat dieses Verfahren noch den Vorteil, dass es keine Totzeiten gibt, in der ein Speicher geleert werden muss. Bei sehr kurzen Pixelzeiten hat das ein besseres Signal-Rausch-Verhältnis zur Folge.

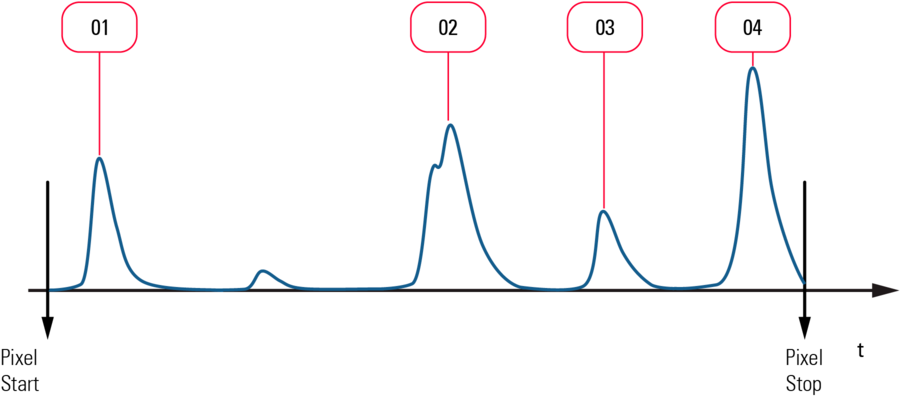

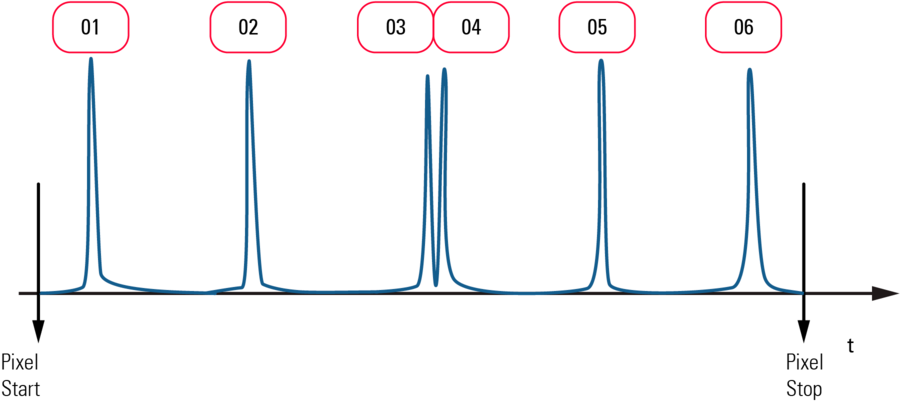

Photonenzählung

Nun haben wir sehr schöne, klare und einfache Histogramme, um die Intensitäten zu beschreiben. Interessanterweise ist die Welt aber gar nicht so glatt und kontinuierlich. Wie Max Planck (1900) gegen seinen Wunsch herausgefunden hat, kommt Licht nicht in kontinuierlicher Intensität vor. Deshalb messen wir mit unseren Detektoren auch keine kontinuierliche Intensitäten, sondern einzelne Ereignisse, das Eintreffen von Photonen. Das scheinbare Kontinuum entsteht aus der messtechnischen Unschärfe: die Histogramme bei analogen Messverfahren mit einem PMT zeigen die Verschmelzung unscharfer Messungen. Ein Photon am PMT erzeugt einen mehr oder weniger breiten Puls, zunächst ansteigend in seiner Intensität und dann wieder abfallend. Aus der Integration oder Mittelung vieler solcher unterschiedlich breiter und unterschiedlich hoher Pulse entsteht dann ein scheinbar kontinuierliches Histogramm von Helligkeiten, in dem beliebige Werte für die Intensität vorkommen können, deren Zahl zudem von der willkürlichen Entscheidung abhängt, mit welcher „Grautiefe“ die Daten aufgezeichnet werden. Die Wirklichkeit verhält sich aber keineswegs so. Die Helligkeit in einem Bildpunkt ist genau besehen nicht durch eine rationale Zahl darstellbar, sondern kann nur eine ganze Zahl sein, und zwar genau die Zahl der Photonen, die während der Messzeit in diesem Pixel am Detektor eingetroffen sind1. Statt die Ladung (z.B. die Fläche unter der Pulskurve) der einzelnen Pulse zu integrieren oder zu mitteln, wäre es also wünschenswert, die an der Anode eintreffenden Ladungspulse zu zählen, ohne die Größe der Pulse auszuwerten. Damit hätte man einen großen Teil der Rauschproblematik gelöst.

1Tatsächlich ist die Intensität des Lichtes auch von der Farbe der Photonen abhängig, und die Pulshöhen werden auch hierdurch etwas variieren. Für den gesamten Bereich macht diese Energiedifferenz aber nur etwa 2 eV aus, verglichen mit etwa 80 V an der ersten Dynode ist das vernachlässigbar. Bei den unten besprochenen Hybrid-Detektoren (HyD), ist diese Variation nochmals etwa 100-fach unbedeutender.

Dasselbe trifft auch für die Anfangsgeschwindigkeit der Photoelektronen zu, die ja in beliebiger Richtung aus der Kathode austreten können, weshalb manche schon in die gewünschte Richtung fliegen, andere aber erst durch einen Richtungswechsel beschleunigt werden müssen, der die kinetische Energie beim Auftreffen auf die Dynode reduziert. Auch hier sind die Variationen nur im Bereich von ±2 eV.

Solche Zählwerke sind elektronisch mittlerweile Standard. Man nutzt die Höhe oder eine Flanke der Pulse, um einen Trigger auszulösen, der das Zählwerk jeweils um 1 erhöht. Am Ende des Pixels wird das Zählwerk auf 0 gesetzt (das braucht hier ungefähr keine Zeit), und der Zähler beginnt von neuem. Man kann aus Abbildung 11 aber auch sofort sehen, wo dieses Verfahren seine Grenzen hat: die Pulse müssen natürlich getrennt wahrgenommen werden. Kommt während eines Pulses noch ein zweiter hinzu, wird nur ein Puls erkannt, und die schließlich gemessene Helligkeit ist zu gering. Ob die Pulse getrennt werden, hängt vom Abstand der Pulse und von der Pulsbreite ab. Breite Pulse erlauben nur geringe Helligkeiten für das Photonenzählverfahren, da sonst die Pulse zu schnell aufeinander folgen und sich möglicherweise überlagern. Schmale Pulse können auch bei größeren Intensitäten, d.h. bei geringeren Pulsabständen, noch gute Zählergebnisse liefern.

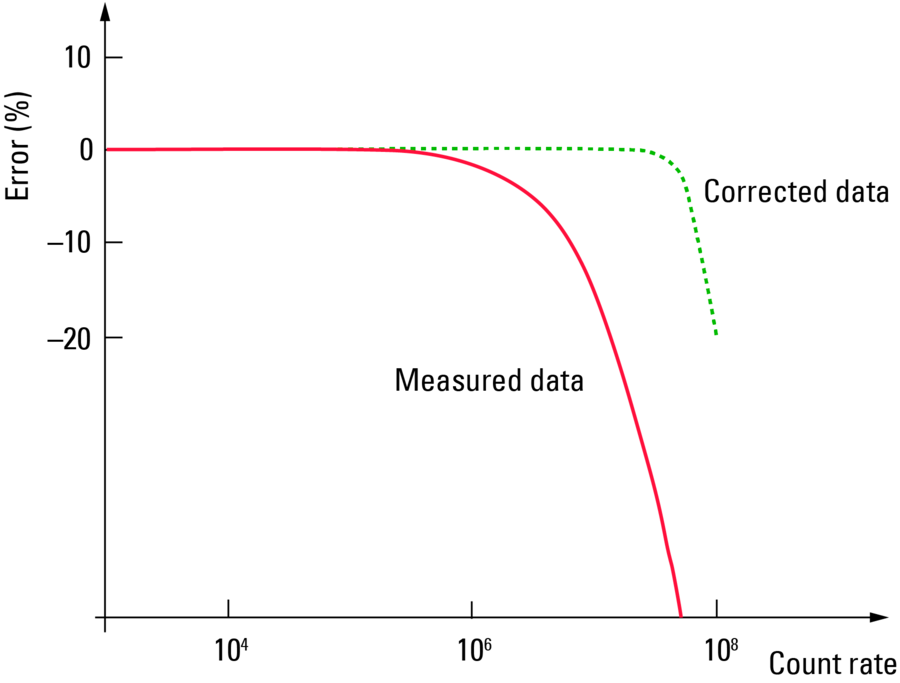

Ein typischer PMT liefert Pulse mit einer separierbaren Breite von etwa 20 ns. Würden Photonen immer mit gleichen zeitlichen Abständen eintreffen, dann ließen sich damit Zählraten bis 50 Millionen pro Sekunde (50 Mcps) realisieren. Da die Photonen aber stochastisch eintreffen, ist eine Überlappung viel wahrscheinlicher und die höchste Zählrate verringert sich. Mit der höchsten Zählrate ist gemeint, dass die Abhängigkeit zwischen der Anzahl der tatsächlich ausgelösten Photoelektronen und der gemessenen Anzahl der Pulse oberhalb dieser Zählrate nicht mehr linear ist. Das ist freilich eine willkürliche Festlegung, die vom tolerierten Fehler abhängt. Erlaubt man nur 1% Abweichung, dann endet die Linearität bei 0,5 Mcps, bei 10% sind es noch 5 Mpcs. Ein Prozent Genauigkeit ist in der täglichen Praxis ohnehin nicht zu erreichen, 10 Prozent schon über der Grenze, die man noch erträglich findet. So kann man die Grenze beispielsweise bei 6% ansetzen und erreichtdann eine brauchbare Messung bis zu Zählraten von etwas über 10 Mcps.

Wenn wir für einen Moment davon ausgehen, dass die Helligkeit nicht schwankt (z.B. durch Beleuchtung eines festen Punktes, ohne Rasterbewegung), dann treffen die Photonen im Mittel gleichmäßig, aber stochastisch am Detektor ein. Die Zeitabstände zwischen zwei Photonen lassen sich bei einem solchen Poisson-Prozess durch eine Exponentialverteilung beschreiben. Wir brauchen hier auf die Details nicht einzugehen, wichtig ist nur, dass sich ein solcher Prozess exakt mathematisch beschreiben lässt. Wir können damit in gewissem Umfange den Fehler ausrechnen, der durch die Überlagerung von Pulsen entsteht und die Abweichung von der Linearität verursacht. Wenn der Fehler aber bekannt, ist, dann lässt sich aus der gemessenen Zahl der Pulse zurückrechnen, wie groß die Zahl der eingetroffenen Pulse tatsächlich war. Das funktioniert etwa bis zum Fünf-fachen der Pulsrate, bei der ohne Korrektur der Fehler signifikant wurde. Man nennt diese Korrektur darum eine Linearisierung und sie ist ein wohlbekanntes und gut beschriebenes Verfahren zur Erweiterung des Messbereiches [7].

Abb. 12: Linearisierung der Zählraten durch Korrektur der statistischen Wahrscheinlichkeiten. Man beachte die logarithmische x-Achse [6].

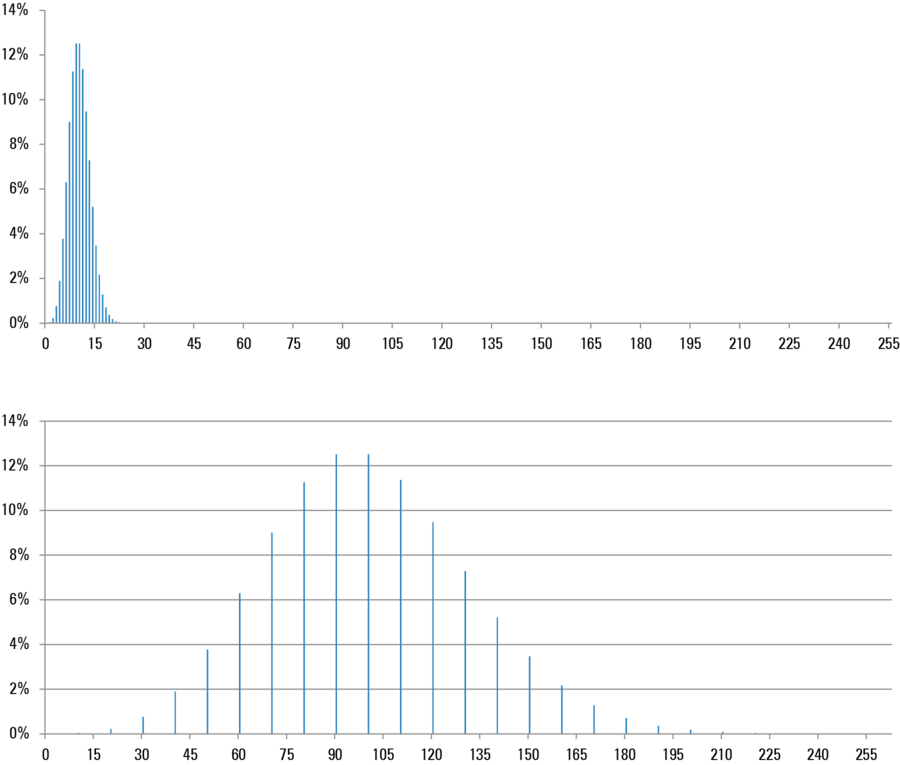

Bei dieser Linearisierung werden nun – ebenso wie bei der Spreizung – statt der ursprünglich gezählten Pulse (den Photonen entsprechend) – statt ganzer Zahlen auch Brüche bei der Berechnung auftreten. Das hat wiederum Auswirkungen auf die Histogramm-Darstellung, bei der naturgemäß nur ganze Zahlen, beispielsweise Grauwerte, auftreten. Jedenfalls sind für gewöhnlich die Breiten dieser Energiekanäle immer konstant, und man kann eventuell gebrochene Werte immer in ganzzahlige umwandeln, etwa indem man bei 0 beginnt und dann einfach weiterzählt. Durch die Linearisierung treten daher in den Histogrammen Schwebungseffekte auf, sodass einzelne Energiewerte deutlich über die Einhüllende des Histogramms hinausragen. Dies wird zunächst intuitiv als störend empfunden, aber es spiegelt exakt den Sachverhalt der statistisch korrigierten Photonenzahlen wieder.

Die Lawinen-Photodiode

Natürlich gibt es mittlerweile auch in der Halbleitertechnik lichtempfindliche Bauteile, die zur Messung von Intensitäten eingesetzt werden können. Am ehesten mit einem Photonenvervielfacher vergleichbar ist die Lawinen-Photodiode (Avalanche Photodiode, APD.

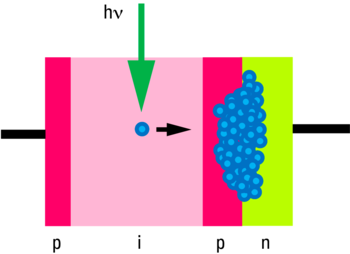

Photonen zu Ladungspaaren

Für die Lichtmessung mit Halbleitern macht man sich den inneren Photoeffekt zu nutze. Hierbei wird in einem sehr schwach dotierten Halbleitermaterial nach Absorption eines Photons ein Ladungspaar erzeugt (freies Elektron und diffusibles „Loch“). Die absorbierende Schicht ist zwischen einer p- und einer n- dotierten Schicht eingebettet, und wirkt daher wie eine Vergrößerung der Raumladungszone, die an einer direkten pn-Grenze entstünde. Die Schicht wird als „i“-Schicht gekennzeichnet, weil sie nur Eigenleitung zeigt (intrinsic conductivity). Der Schichtfolge wegen, bezeichnet man solche Halbleitersysteme als pin-Dioden. Liegt an den Elektroden einer solchen Photodiode eine Spannung in Sperr-Richtung an, wird ein Strom fließen, der über einen großen Bereich proportional zur Intensität des einfallenden Lichtes ist. Allerdings ist für schwache Signale eine solche Diode nicht empfindlich genug und zeigt zu hohe Rauschanteile.

Der Lawineneffekt

Um auch schwache Signale messen zu können, wird die pin-Anordnung durch eine weitere Schicht ergänzt: zwischen die i- und n-Schicht wird nochmals eine hoch dotierte p-Schicht eingesetzt. Die hier sich ausbildenden sehr hohen Feldstärken haben zur Folge, dass die Ladungen stark beschleunigt wer-den, und ihre Energie bei Stößen mit den Gitterelementen abgeben, wobei weitere Ladungen erzeugt werden (daher der Ver-gleich mit dem PMT). Auch diese Ladungen werden beschleunigt, wodurch der Prozess lawinenartig anschwillt und zu einem Puls im Messkreis führt. Bei mäßigen Spannungen bricht die Lawine von alleine wider ab, und es lassen sich Verstärkungen bis zu etwa 102-fach erreichen. Bei sehr hohen Sperrspannungen wird die Verstärkung extrem (bis zu 108-fach), aber der Strom muss aktiv unterbrochen werden, um das Bauteil nicht zu zerstören. Dieser letztere Fall wird als „Geiger-Modus“ bezeichnet, da er geeignet ist, einzelne Photonen ohne zusätzliche Verstärkung nachzuweisen. Der Nachteil im Geiger-Modus ist die lange Totzeit nach einem gemessenen Ereignis, daher ist dieser Modus zur Aufzeichnung von Bildern in der Regel ungeeignet.

Unterschiede zum PMT

Im Gegensatz zu Photoelektronenvervielfacherröhren haben Lawinen-Photodioden nur einen geringen dynamischen Bereich, man muss daher stets dafür sorgen, dass die Intensität des zu messenden Lichtes nicht zu groß wird. Die Verstärkung im nicht-Geiger Modus liegt bei 100x bis 1000x, je nach angelegter Spannung. Dafür zeigen solche Sensoren einen sehr geringen Dunkelstrom, sind also gut für schwache Signale geeignet, die bei zu hohem Dunkelstrom im Hinter-grundrauschen untergehen würden. Die spektrale Empfindlichkeit überstreicht einen großen Bereich von 300 nm bis über 1000 nm, weshalb insbesondere für rote Fluoreszenzemissionen APDs auch zur Aufzeichnung von Bildern benutzt werden. Obwohl die Empfindlichkeit im Roten Bereich sehr hoch ist, ist das thermische Rauschen dennoch vergleichsweise klein. Dieses Rauschen hängt von der Sensorfläche ab, die bei APDs 0,1 mm2 nicht übersteigt, während PMTs Sensorflächen bis zu 10 mm2 aufweisen.

Die Pulse bei APDs sind sehr schmal, was für Photonenzählung ja eine wichtige Eigenschaft ist. Allerdings lässt sich dies nur im nicht-Geiger Modus nutzen, da andernfalls der Vorteil durch die sehr langen Totzeiten (einige 10 ns) wieder zunichte gemacht wird.

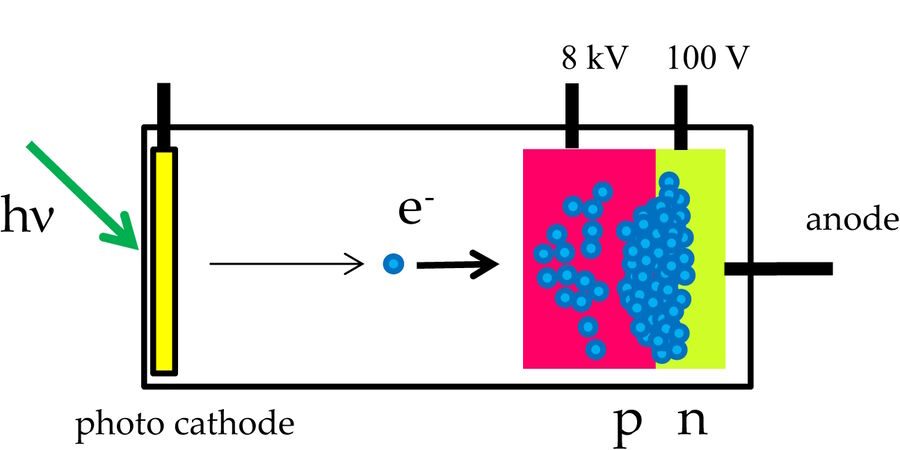

Der Hybrid-Detektor

Es wäre doch schön, wenn man die hohe Dynamik eines PMT mit der Geschwindigkeit und Rauscharmut einer APD verbinden könnte. Eben dies wurde mit einer chimären Technologie aus Vakuum-Röhre und Halbleiter-Baustein realisiert. Das Ergebnis ist ein Hybrid-Detektor (HyD; auch HPD: Hybrid Photo Detector oder HPMT: Hybrid Photo Multiplier Tube).

In diesem Baustein werden tatsächlich die beiden Technologien so miteinander kombiniert, dass im Ergebnis ein Sensor zur Verfügung steht, der die positiven Eigenschaften von PMT und APD miteinander verbindet.

Aufbau

Der „Eingang“ eines HyD ist identisch mit dem eines PMT: eine Photokathode in einer evakuierten Röhre kann durch Absorption ein Photoelektron freisetzen. In der Regel wer-den GaAsP-Kathoden eingesetzt, die auch bei PMTs für die biomedizinische Fluoreszenzanwendung am geeignetsten ist. Im Gegensatz zum PMT wird dieses Photoelektron aber nicht stufenweise, sondern in einem einzigen Schritt sehr stark beschleu-nigt. Dabei wird eine Potentialdifferenz von über 8000 Volt durchschritten.

Man kann schon hier erkennen, dass die Unterschiede in der relativen Pulshöhe viel geringer sind, als bei einem PMT, bei dem die Beschleunigungsspannung zur ersten Dynode etwa 100 Volt beträgt. Wie im Kapitel "Die Photoelektronenvervielfacherröhre" beschrieben, werden an der ersten Dynode zwischen 2 und 4 Elektronen freigesetzt, wobei eine Streuung von 1 bis 2 Elektronen zu erwarten ist. Deshalb schwanken die Pulshöhen dort üblicherweise um einen Faktor 3 bis 5. Im Gegensatz dazu werden in einem Hybrid-Detektor die Photoelektronen um 8 kV beschleunigt. Man erhält aus der kinetischen Energie etwa 1500 Sekundärelektronen. Die Schwankungen liegen demnach bei 40 Elektronen (√1500). Das ist absolut zwar mehr als 2 bis 4 Elektronen, aber relativ zu 1500 sind es nur 3%. Die am Ausgang entstehenden Pulse sind also sehr homogen und spiegeln viel genauer die Energieverhältnisse der Beleuchtung wieder.

Das hoch beschleunigte Photoelektron trifft nun nicht auf eine Dynode (die mit solchen Energien nicht zurechtkäme), sondern auf einen Halbleiter. Hier wird die Energie in sehr viele Ladungspaare umgesetzt (wie oben erwähnt, ca. 1500). Durch eine angelegte Spannung bewegt sich diese Ladung in Richtung einer Multiplikationsschicht, wie sie für die APD beschrieben wurde (Lawinen-effekt). Hier wird das Signal nochmals etwa 100-fach verstärkt und so zu einem messbaren Puls.

Datenaufzeichnung mit einem HyD

Durch die einstufige Beschleunigung und der anschließend direkten Verstärkung gibt es viel weniger Streuung bei den Trajektorien der Ladungen, was zur Folge hat, dass die Pulse viel schärfer sind, als bei einem PMT: die Pulsbreite fällt etwa 20x geringer aus und unterschreitet 1 ns (aktuell, d.h. September 2015, bei 0,5 ns).

Hinzu kommt, dass durch den Wegfall der Dynoden und einer viel kleineren Photokathode auch deutlich weniger Dunkelereignisse eintreten. Das Hintergrund-rauschen ist daher im Vergleich zu einer Photoelektronenvervielfacherröhre ebenfalls deutlich geringer. Das führt nicht nur zu einem besseren Kontrast bei der Bildauf-nahme selbst, sondern erlaubt auch, Bilder in größerer Zahl zu mitteln oder zu akkumu-lieren. Da der Hintergrund fast völlig schwarz ist, bleibt er auch dann noch schwarz, wenn viele Bilder in einem zusammengefasst werden, womit man bei hohem Kontrast das Signalrauschen deutlich verringern kann.

Der Hybrid-Detektor hat also sehr viele Vorteile. Durch die homogenen und schmalen Pulse kann man mit einem HyD auch bei Lichtströmen Photonen zählen, bei denen ein PMT schon längst übersättigt ist. Deshalb ist es sinnvoll, Hybrid-Detektoren im Photonenzählmodus auch für „gewöhnliche“ Bildaufzeichnung zu verwenden. Wie in Kapitel "Photonenzählung" erläutert, hat das Photonenzählen ja viele Vorteile gegenüber den analogen Nachweisverfahren.

Bei der Auswertung bekommt man konsequenter Weise keine durch Rauschen „verschmierten“ und quasi-kontinuierlichen Histogramme, sondern erwartungsgemäß gut getrennte Häufigkeiten von wenigen Photonen. Abbildung 9 zeigt tatsächlich so ein Histogramm. Oben sieht man die Poisson-Verteilung für einen Mittelwert von 10 Photonen pro Pixel, unten dieselbe Information auf 256 Grauwerte (für die Darstellung auf einem Monitor) aufgespreizt.

Das Leica TCS SP8 System bietet mit Hybrid-Detektoren drei unterschiedliche Datenaufnahmeverfahren zur freien Auswahl. Zum einen kann man die Rohdaten der Photonenzählung als Bildinformation verwenden (Modus: „Photon Counting“). Da hier auf Linearisierungsverfahren verzichtet wird, ist die Höchstzählrate kleiner als für den Fall der linearisierten Daten, aber immer noch deutlich höher als für herkömmliche Photomultiplier. Man erreicht etwa 60 Mcps (vgl. Kapitel "Photonenzählung" zur Erläuterung).

Werden die gezählten Ereignisse durch die oben beschriebene mathematische Linearisierung korrigiert, wird die Höchstzählrate um einen Faktor 5 verbessert und man kann Helligkeiten bis zu 300 Mcps aufzeichnen. Da hier die Photonen in Werte umgerechnet werden, die nicht mehr notwendig ganze Zahlen darstellen, ist es sinnvoll, auch gleich eine Skalierung vorzunehmen, sodass die Helligkeiten vergleichbar mit herkömmlichen Sensoren werden, und für eine ausgewogene Darstellung auf einem Monitor taugen. Dieses Verfahren wird als „Standard“ geführt. Man beachte, dass die Histogramme durch Spreizung und Rundungseffekte „seltsam“ aussehen können. Die gemessenen Zahlen bei der Auswertung von Helligkeiten in Bildern sind dennoch korrekt.

Für eine bessere Wahrnehmbarkeit des gesamten ausgeschöpften dynamischen Bereiches kann man die Werte auch so verändern, dass helle Bildpunkte weniger, dunkle Bildpunkte aber stärker betont werden. Das entspricht im Ergebnis den Verfahren, die mit HDR erreicht werden. Dieser Modus ist mit „Bright R“ bezeichnet. Er dient dazu, Proben mit stark unterschiedlicher Helligkeit so darzustellen, dass die hellen Bildbereiche nicht überstrahlen, die dunklen aber immer sichtbar bleiben. Ein Beispiel dafür wären Neuronen mit sehr viel Farbstoff im Zellsoma und sehr dünnen Dendriten.

| Modus | Skalierung | Linearisierung | Erhöhte Dynamik |

|---|---|---|---|

| Photon counting | nein | nein | nein |

| Standard | ja | ja | nein |

| Bright R | ja | nein | ja |

Literaturhinweise

- Becquerel AE: Mémoire sur les effets électriques produits sous l’influence des rayons solaires. Comptes Rendus 9: 561–67 (1839).

- Hertz HR: Ueber den Einfluss des ultravioletten Lichtes auf die electrische Entladung. Annalen der Physik 267 (8): 983–1000 (1887).

- Hallwachs WLF: Ueber die Electrisierung von Metallplatten durch Bestrahlung mit electrischem Licht. Annalen der Physik 34: 731–34 (1888).

- Einstein A: Ueber einen die Erzeugung und Verwandlung des Lichtes betreffenden heuristischen Gesichtspunkt. Annalen der Physik 322 (6): 132–48 (1905).

- Newton I: Opticks. Or, A Treatise of the Reflections, Refractions, Inflections and Colours of Light (1704).

- Planck M: Ueber irreversible Strahlungsvorgänge. Ann. Phys, 1: 69–122 (1900).

- Hamamatsu Photonics KK: Photomultiplier Tubes – Basics and Applications. Ed. 3a: 310 (2007).